揭秘Multimodal大语言模型:技术巅峰,引领AI新纪元

2022-12-31 23:56:07

Multimodal大语言模型:跨越模态界限,开启AI新时代

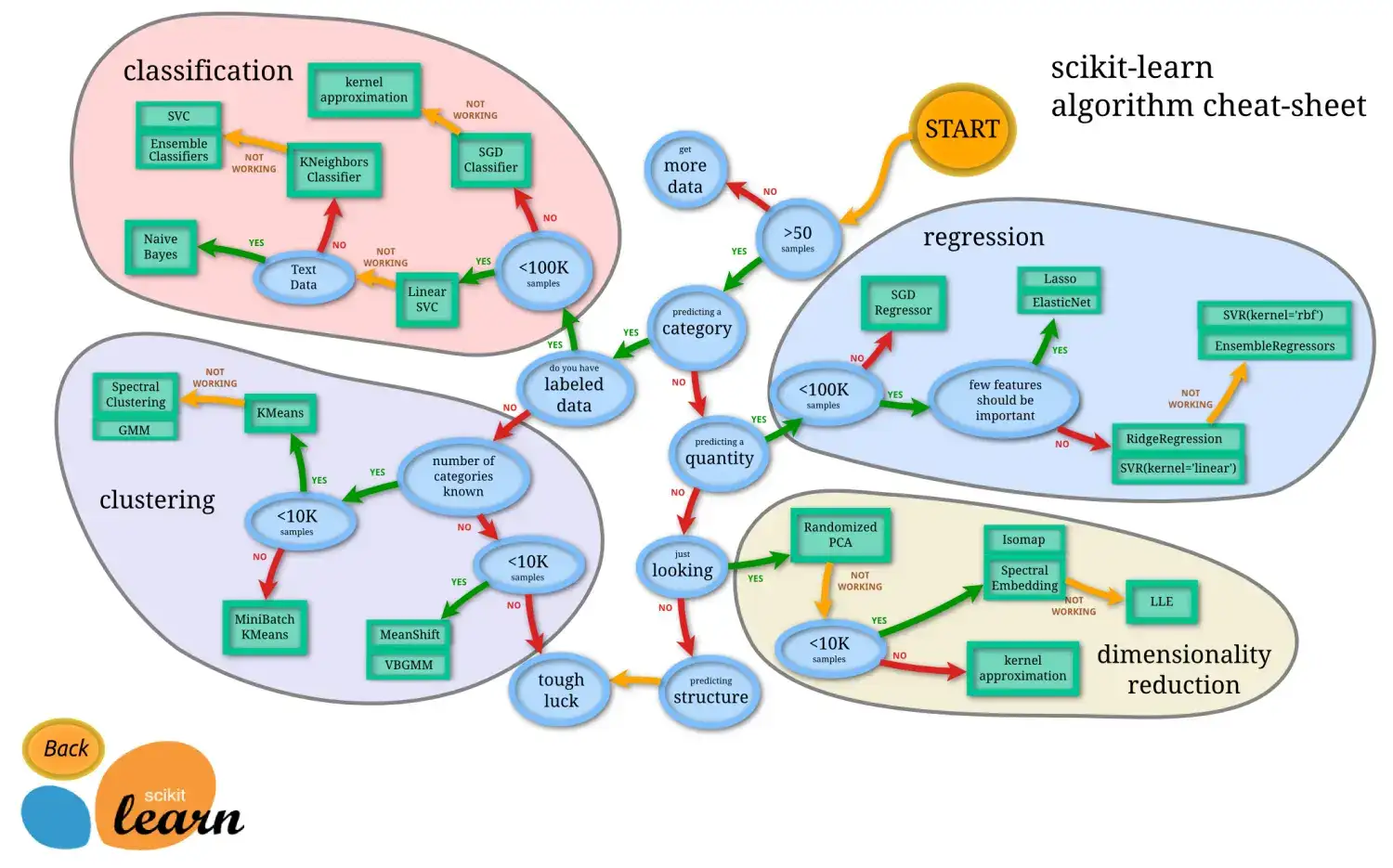

在科技飞速发展的今天,人工智能(AI)正在以前所未有的方式改变着我们的世界。而Multimodal大语言模型(MM-LLM)的出现,无疑是AI领域的一场革命。这些模型突破了传统语言处理的局限,具备处理多种模态信息的能力,为我们开启了一个更自然、更智能的人机交互时代。

技术要点

1. 知识表示

MM-LLM将来自文本、图像、音频等多种模态的数据融合在一起,构建出更加丰富的语义知识库。这种跨模态的知识整合赋予了AI更深入的理解和分析能力,使其能够建立更加复杂的推理和决策。

2. 学习目标

与传统语言模型不同,MM-LLM专注于多模态信息的综合理解和生成。它们通过训练理解不同模态信息之间的关联,以及在多种模态之间进行转换和生成新的内容。

3. 模型结构

MM-LLM利用神经网络的特性,构建出兼容多模态信息处理的网络结构。这些模型可以同时处理文本、图像、音频等不同类型的输入,并将其转化为统一的中间表示,以便进行后续的处理和生成。

4. 信息融合

信息融合是MM-LLM的核心能力。通过融合来自不同模态的信息,它们可以实现更准确、更全面的数据理解。这种多模态融合有效地消除了单一模态数据的局限性,使AI能够获得更加深入的洞察。

5. 提示(Prompt)使用

提示在MM-LLM的学习和应用中至关重要。通过提供明确、简洁的提示语,我们可以引导AI模型的学习方向,提升生成内容的相关性和准确性。提示的质量直接影响着模型的输出效果。

应用前景

1. 多模态信息检索

MM-LLM能够同时处理文本、图像、音频等多种形式的信息。这极大地提高了信息检索的效率和准确性。无论用户是搜索图像、文档还是视频,MM-LLM都可以快速提供相关且全面的结果。

2. 机器翻译

MM-LLM打破了语言和文化隔阂。它们不仅能够翻译文本,还能翻译语音、视频等不同语言的多种形式信息。这将极大便利国际交流,促进全球化合作。

3. 视觉问答

MM-LLM能够理解图像和文本的组合问题,并给出准确的答案。这可以帮助人们更好地理解视觉信息,例如,通过图片识别不同物体、场景或人物。

4. 创意内容生成

MM-LLM拥有创造原创音乐、艺术作品、文学作品等跨模态内容的能力。这为创意工作者带来了无限灵感,打破了传统的创作模式,激发新的创意可能性。

5. 医疗诊断

MM-LLM能够整合患者的图像、文本和语音等信息,帮助医生进行更准确的诊断和治疗。通过分析这些多模态数据,AI可以识别潜在的疾病,为患者提供更个性化和有效的治疗方案。

代码示例

# 导入必要的库

import transformers

# 初始化一个MM-LLM模型

model = transformers.AutoModelForSeq2SeqLM.from_pretrained("google/t5-large- multimodal")

# 定义文本输入

text = "Generate a poem about a lonely tree."

# 定义生成提示

prompt = "Poem: "

# 使用MM-LLM生成文本

generated_text = model.generate(text, prompt=prompt)

# 打印生成的文本

print(generated_text)

结论

Multimodal大语言模型的出现标志着AI技术的一大飞跃。它们跨越了模态界限,为我们带来前所未有的信息理解和生成能力。从日常生活到科学研究,MM-LLM将在各行各业发挥重要作用,推动AI技术的发展和应用,为人类社会带来无限可能。

常见问题解答

1. MM-LLM与传统语言模型有什么区别?

MM-LLM超越了传统的语言处理能力,能够处理多种模态信息,如图像、音频等。这赋予了它们更深入的理解和生成能力。

2. MM-LLM有哪些应用场景?

MM-LLM的应用场景广泛,包括多模态信息检索、机器翻译、视觉问答、创意内容生成和医疗诊断等。

3. MM-LLM的学习方式是什么?

MM-LLM通过大规模多模态数据集进行训练,学习理解和生成跨模态内容。

4. MM-LLM的局限性是什么?

MM-LLM仍在发展阶段,可能存在生成内容不准确、偏见或不连贯等局限性。

5. MM-LLM的未来发展趋势是什么?

随着技术的不断进步,MM-LLM有望进一步提升其能力,在更广泛的应用场景中发挥作用,推动AI技术的不断革新。