机器学习的秘密武器:揭开支持向量机(SVM)的奥秘

2023-06-18 16:21:30

走进支持向量机(SVM)的奇妙世界:用 Python 踏上分类和回归之旅

一、SVM 的分类秘诀

想象一下你手中握着一把锋利的剑,准备将一堆混合在一起的苹果和橘子一分为二。SVM 就如同一把这样的剑,它会找到最优的分割线,将苹果和橘子完美地分开,不会遗漏任何一个。

SVM 的魔法在于它总能找到一个 "超平面",这个超平面就是分割线,将不同类别的数据完美地隔离开来。它就像一道无形的墙,将数据分成了两个不同的世界。

为了找到最优的超平面,SVM 会使用一种叫做 "最大间隔分类" 的策略。它会寻找一条距离正负样本都有最大间隔的超平面,这样可以确保分类的准确性。

二、SVM 的回归奥义

SVM 不仅仅擅长分类,它在预测连续值方面也能大展身手。回归的目的就是找到一条最优的曲线,让它能够最好地拟合数据。

SVM 的回归方法叫做 "支持向量回归 (SVR)",它会找到一条能够最小化预测误差的曲线。这条曲线就是 SVR 的回归函数,它能够帮助我们预测连续型数据的变化趋势。

三、走进 SVM 的非线性世界

SVM 的强大之处在于,它不仅能处理线性的问题,还能轻松应对复杂的非线性问题。它会使用一种叫做 "核技巧" 的魔法,将非线性数据映射到高维空间,然后在高维空间中构建线性超平面进行分类或回归。

核技巧就像一个神奇的传送门,它能够将数据从非线性世界带到线性世界,让 SVM 能够在高维空间中轻松解决复杂的问题。

四、用 Python 体验 SVM 的魅力

现在,让我们用 Python 的 Scikit-Learn 库来构建一个 SVM 模型,看看它如何将数据分得清清楚楚。

# 导入必要的库

import numpy as np

import pandas as pd

from sklearn.svm import SVC, SVR

# 加载数据

data = pd.read_csv('data.csv')

# 构建 SVM 分类器

clf = SVC()

# 训练模型

clf.fit(data.drop('target', axis=1), data['target'])

# 预测结果

predictions = clf.predict(data.drop('target', axis=1))

# 评估模型

accuracy = np.mean(predictions == data['target'])

print('分类准确率:', accuracy)

# 构建 SVR 回归器

reg = SVR()

# 训练模型

reg.fit(data.drop('target', axis=1), data['target'])

# 预测结果

predictions = reg.predict(data.drop('target', axis=1))

# 评估模型

rmse = np.sqrt(np.mean((predictions - data['target']) ** 2))

print('回归均方根误差:', rmse)

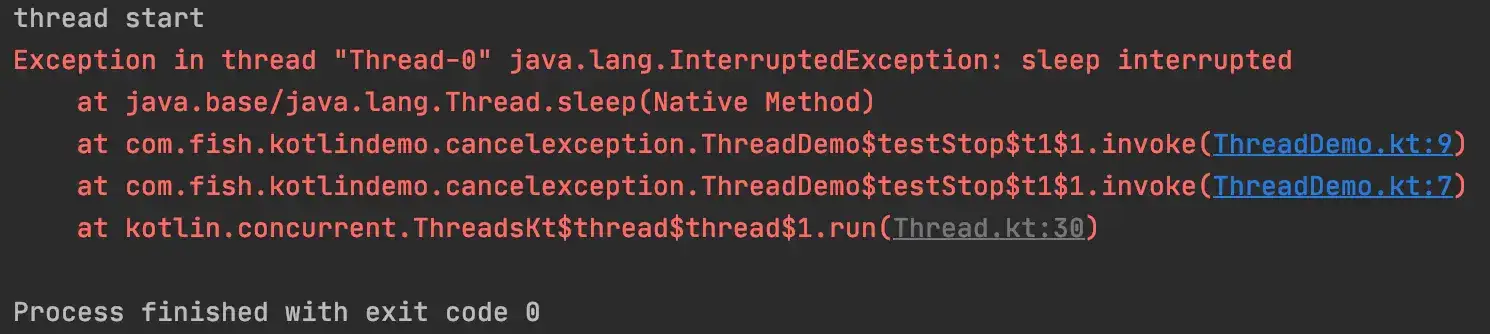

运行这段代码,你就会看到 SVM 模型是如何将数据分得清清楚楚的。它会输出分类准确率和回归均方根误差,让你直观地看到模型的性能。

五、常见的 SVM 问题解答

- 如何选择最佳的 SVM 核?

不同的核函数适用于不同的数据类型和问题。常见的核函数包括线性核、多项式核和径向基核。你可以在训练集上尝试不同的核函数,看看哪个核函数能够产生最好的结果。

- 如何调整 SVM 的参数?

SVM 有两个重要的参数:C 和 gamma。C 控制正则化强度,gamma 控制核函数的形状。你可以使用网格搜索或交叉验证来找到最优的参数组合。

- SVM 对噪声数据敏感吗?

SVM 对噪声数据比较敏感,因为噪声数据可能会导致超平面偏移。你可以通过使用正则化或采样技术来减轻噪声的影响。

- 如何处理高维数据?

高维数据可能会导致 SVM 训练速度变慢和内存使用量增加。你可以使用降维技术,例如主成分分析 (PCA),来降低数据的维度。

- SVM 适用于哪些实际问题?

SVM 已成功应用于各种实际问题,包括图像识别、自然语言处理和欺诈检测。

结论

SVM 是一种强大的机器学习算法,可以用于解决分类和回归问题。它具有找到最优决策边界的强大能力,并且可以处理非线性数据。

通过了解 SVM 的基本原理和实践方法,你将能够充分利用它的能力来解决各种现实世界的问题。