窗口函数:掌握 SQL、Pandas、Spark 中的强大分析工具

2024-01-31 01:28:31

数据分析中的窗口函数:SQL、Pandas 和 Spark 的强大工具

在数据分析的浩瀚海洋中,窗口函数犹如指路明灯,照亮我们探索数据组内奥秘的道路。从基本的排名到复杂的滑动平均,它们为更深入的见解和更明智的决策铺平了道路。了解这些强大工具在 SQL、Pandas 和 Spark 中的不同实现方式,将使您在数据分析的道路上如鱼得水。

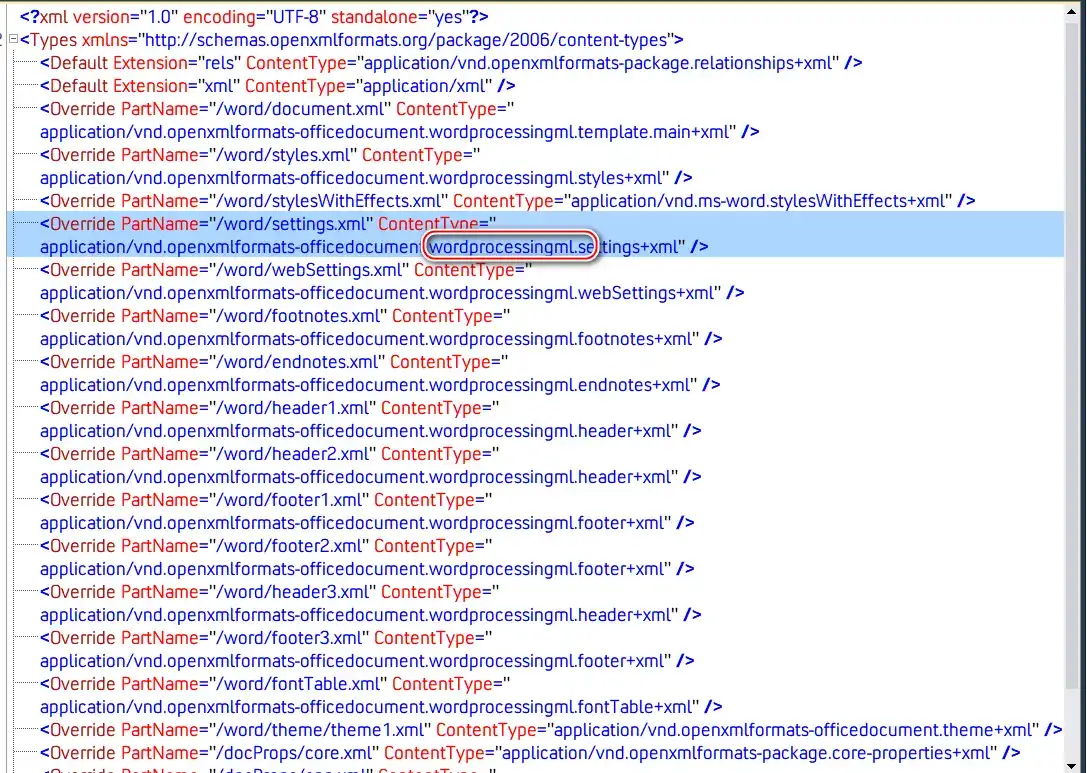

SQL 中的窗口函数:洞察行组

SQL 中的窗口函数让我们能够在一个特定窗口(即一组行)内进行计算,就像给数据集套上了一层滤镜。我们可以根据行号、日期范围或组 ID 等条件定义窗口,深入挖掘数据内部的关联和趋势。

示例:平均交易金额

考虑一个记录交易数据的表,我们需要找出每位客户的平均交易金额。窗口函数在这里大显身手:

SELECT

customer_id,

AVG(amount) OVER (PARTITION BY customer_id) AS avg_amount

FROM

transactions;

这段查询将为每位客户创建一个新的列 avg_amount,其中存储着他们的平均交易金额。

Pandas 中的窗口函数:探索时间序列

Pandas,一个强大的 Python 库,也为我们提供了与 SQL 类似的窗口函数。通过它,我们可以轻松地对 DataFrame 中的组内数据进行计算,尤其适用于时间序列分析。

示例:前 3 笔交易总额

使用 Pandas 读入交易数据表后,我们就可以利用窗口函数来计算每位客户前 3 笔交易的总额:

df['running_total'] = df['amount'].rolling(3).sum()

这个操作为 DataFrame 添加了一列 running_total,其中包含了每位客户前 3 笔交易的总额。

Spark 中的窗口函数:大规模计算

Apache Spark,一个专为大数据处理而生的分布式计算框架,也提供了一套全面的窗口函数 API。凭借其强大的计算能力,我们可以对海量数据集进行组内计算,为更具洞察力的分析奠定基础。

示例:每周平均交易金额

使用 Spark 读入交易数据表后,我们可以用窗口函数来找出每种产品的每周平均交易金额:

window = Window.partitionBy('product_id').rangeBetween(-7, 0)

df.withColumn('weekly_avg', avg('amount').over(window)).show()

这段代码为 DataFrame 添加了一列 weekly_avg,其中存储着每种产品的每周平均交易金额。

结论:驾驭数据分析的新高度

窗口函数为数据分析带来了革命性的变化,让我们能够深入探索数据组内的细微差别。通过了解 SQL、Pandas 和 Spark 中窗口函数的不同实现方式,我们可以解锁数据中的宝贵见解,做出更有根据的决策。掌握这些工具将帮助您在数据分析的道路上更上一层楼,从数据中挖掘出真正的价值。

常见问题解答

-

窗口函数有哪些常见的类型?

窗口函数主要分为基于行的(如排名)和基于范围的(如滑动平均)。 -

如何在 SQL 中定义窗口?

可以使用PARTITION BY和ORDER BY子句来定义窗口。 -

Pandas 中的

rolling方法如何工作?

rolling方法创建一个移动窗口,在数据组内计算聚合。 -

Spark 中的窗口范围如何指定?

Spark 中的窗口范围可以使用rangeBetween或rangeUnbounded等方法指定。 -

窗口函数在哪些行业应用广泛?

窗口函数在金融、零售和医疗保健等行业中都有广泛应用。