大语言模型的崛起:数据是关键,谷歌的28个15亿参数模型证明了这一点

2023-12-11 13:48:59

谷歌的 28 个 15 亿参数模型:揭秘数据的力量

随着谷歌宣布其令人印象深刻的突破,LLM(大型语言模型)领域再次掀起轩然大波。该公司训练了 28 个拥有惊人的 15 亿个参数的模型,这展示了其在这一前沿领域的巨大进步。在这个模型的背后,数据扮演着至关重要的角色,我们将在本文中深入探讨其重要性。

数据:LLM 训练的基石

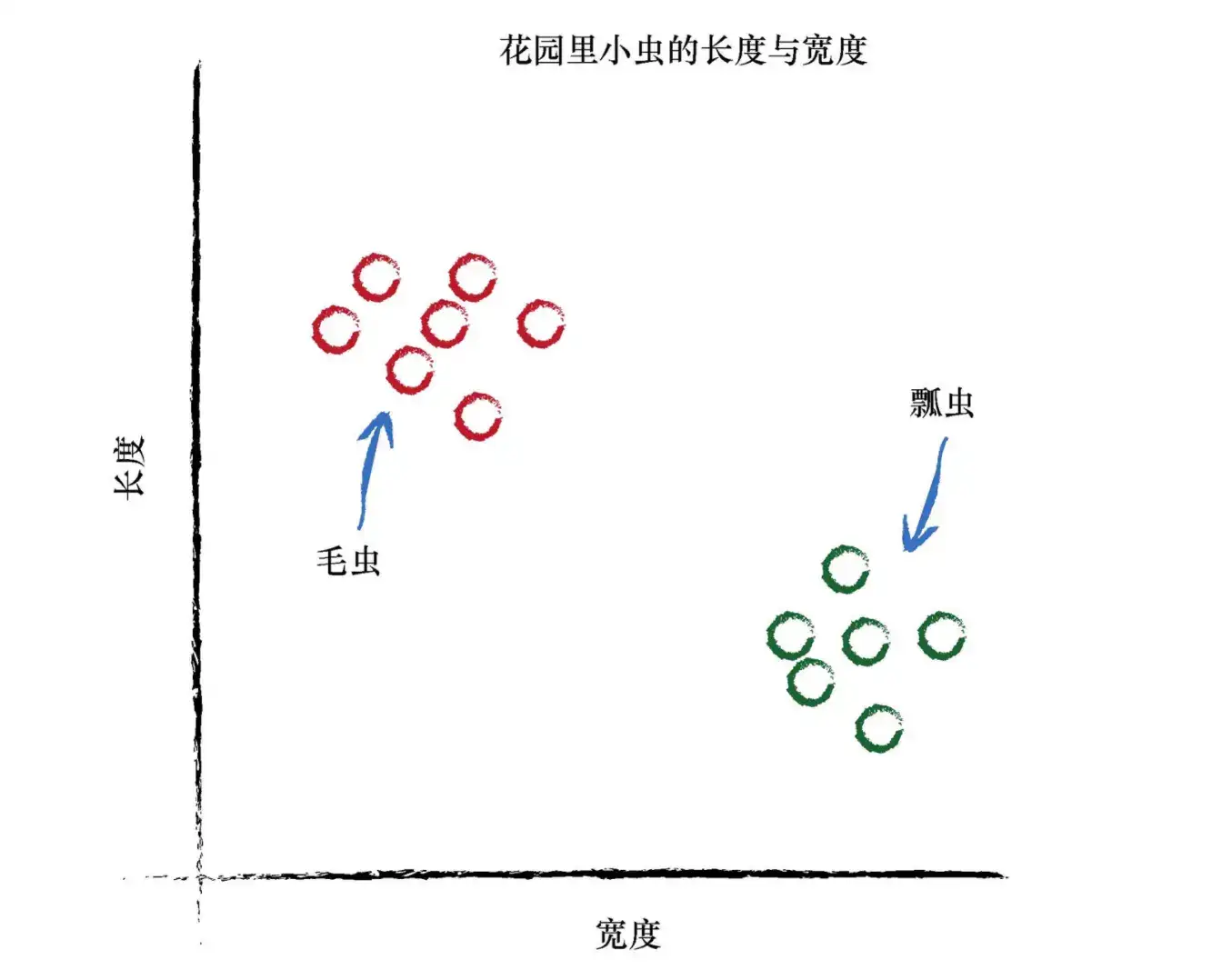

试想一下,你正在学习一门新语言。如果没有大量文本和单词的沉浸式体验,你会发现掌握这种语言并运用自如是多么困难。对于 LLM 来说,情况也是如此。它们需要海量的数据来汲取语言的模式和细微差别。

谷歌模型的成功秘诀:无与伦比的数据集

谷歌的 28 个 15 亿参数模型得益于其无与伦比的数据集,这是全球最大的数据集之一。凭借如此庞大的数据源,谷歌模型可以全面了解语言的复杂性。它可以识别各种语言结构、关联单词和概念,并理解不同的语调和情感。

寻找高质量的数据:关键在于相关性和多样性

并非所有数据都生而平等。为了训练一个强大的 LLM,至关重要的是获得高质量的数据,这涉及两个关键方面:相关性和多样性。

相关性: 数据必须与 LLM 的预期用途相关。例如,如果您正在训练一个 LLM 来回答问题,那么您需要收集包含各种问题和答案的数据。

多样性: 数据必须来自不同的来源和涵盖广泛的主题。这确保 LLM 能够学习语言的各个方面,并适应不同的上下文和语域。

训练 LLMs:代码示例

让我们通过一个 Python 示例来了解 LLM 训练过程的代码方面:

import tensorflow as tf

# 创建一个包含 15 亿个参数的 Transformer 模型

model = tf.keras.models.Sequential()

model.add(tf.keras.layers.Embedding(10000, 512))

model.add(tf.keras.layers.TransformerBlock(num_heads=8, dff=2048))

model.add(tf.keras.layers.Dense(10000))

# 编译模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

# 训练模型

model.fit(X_train, y_train, epochs=10)

结论

数据是 LLM 训练的命脉。谷歌的 28 个 15 亿参数模型展示了拥有丰富且高质量数据集的力量。通过利用其庞大的数据资源,谷歌已创建出能够理解和生成高质量文本的强大模型。

随着技术的进步和数据可用性的不断增加,我们可以期待 LLM 领域进一步取得突破性进展。这些模型有潜力彻底改变我们与计算机交互的方式,使我们能够获得以前无法想象的信息和见解。

常见问题解答

问:LLM 训练需要多少数据?

答:所需的具体数据量取决于模型的大小和复杂性。然而,一般来说,LLM 需要大量的数据,通常以 TB(太字节)为单位。

问:如何确保数据质量?

答:可以通过仔细检查数据、删除重复项和不准确的数据以及确保数据相关且多样化来确保数据质量。

问:LLM 可以执行哪些任务?

答:LLM 可以执行广泛的任务,包括文本生成、翻译、问答、摘要和文本分类。

问:LLM 是否会取代人类作家?

答:虽然 LLM 能够生成印象深刻的文本,但它们不太可能完全取代人类作家。相反,它们可以作为辅助工具,帮助作家提高创造力和效率。

问:LLM 的未来是什么?

答:LLM 的未来充满光明。随着技术的进步和可用数据的增加,我们可以期待 LLM 变得更加强大和多才多艺。它们有潜力在各种行业和应用中产生变革性影响。