返回

利用深度强化学习框架解决金融投资组合管理问题

见解分享

2023-09-01 04:23:00

在金融领域,投资组合管理是一项至关重要的任务,其目标是通过分配资产来最大化投资回报,同时将风险降至最低。传统方法通常依赖于预先定义的策略和假设,但随着深度强化学习(DRL)技术的兴起,我们现在有了探索更复杂和自适应解决方案的机会。本文将探讨如何利用 DRL 框架解决金融投资组合管理问题,并分享一个可用于实际应用的 GitHub 实现。

DRL 在投资组合管理中的应用

DRL 是一种机器学习方法,通过与环境的交互来学习最佳行为策略。在投资组合管理中,环境可以是历史市场数据和实时信息,而强化信号则是投资回报。DRL 代理可以学习识别模式、适应市场变化并自动调整投资组合分配。

DRL 在投资组合管理中的优势包括:

- 学习复杂的策略: DRL 可以学习超出人类直觉或预先定义规则的复杂策略。

- 动态适应性: DRL 代理可以不断从市场数据中学习,并适应不断变化的市场条件。

- 鲁棒性: DRL 算法对噪声和不确定性具有鲁棒性,这在金融市场中非常重要。

我们的 DRL 框架

我们开发了一个 DRL 框架,专门用于解决投资组合管理问题。该框架包括:

- 环境模型: 一个模拟市场动态并提供强化信号的模型。

- DRL 代理: 一个利用神经网络学习最佳行为策略的代理。

- 优化算法: 一种优化代理策略的强化学习算法。

我们的框架基于一个循环神经网络(RNN)代理,它可以学习识别模式并做出预测。代理接受历史市场数据和实时信息作为输入,并产生投资组合分配作为输出。强化信号是投资回报的函数。

GitHub 实现

为了使我们的 DRL 框架更易于使用,我们将其开源并在 GitHub 上提供了实现。该实现包括:

- 示例数据: 用于训练和评估代理的历史市场数据。

- 配置参数: 用于自定义环境和代理设置的配置参数。

- 训练脚本: 用于训练 DRL 代理的脚本。

- 评估脚本: 用于评估代理性能的脚本。

使用指南

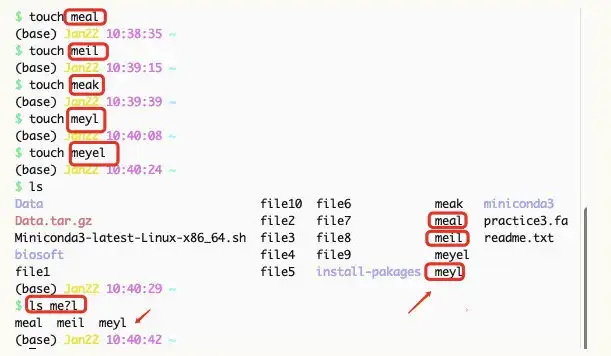

要使用我们的 DRL 框架,您可以按照以下步骤操作:

- 克隆 GitHub 存储库。

- 准备历史市场数据并将其存储在指定位置。

- 根据您的需要调整配置参数。

- 运行训练脚本。

- 运行评估脚本以评估代理性能。

结论

利用 DRL 框架解决金融投资组合管理问题为我们提供了探索复杂和自适应解决方案的机会。我们的开源 GitHub 实现使开发人员和研究人员能够轻松使用我们的框架并进一步研究这一激动人心的领域。我们相信,DRL 在投资组合管理和其他金融应用中具有巨大的潜力,我们期待看到该技术的未来发展。