返回

用 Spark Streaming 进行统计分析的进阶指南

见解分享

2023-09-16 02:12:48

利用 Spark Streaming 掌控实时数据分析

在数据主宰一切的时代,实时分析已成为企业洞察和决策制定的生命线。Apache Spark 的 Spark Streaming 是一个专为处理流数据的强大库,是构建实时分析应用的理想之选。

什么是 Spark Streaming?

Spark Streaming 继承了 Spark 的分布式处理引擎,提供了一套先进的 API,可从各种来源摄取、转换和分析流数据。它支持 Kafka、Flume 和 Twitter 流等数据源,并提供映射、连接和聚合等高级转换。

实时数据摄取

Spark Streaming 可从多种来源实时摄取数据,包括:

- Kafka: 一种分布式流媒体平台,用于处理大量消息流。

- Flume: 一个可靠的分布式数据收集系统,适用于日志聚合和事件数据收集。

- Twitter Streaming API: 提供对公共 Twitter 数据流的访问。

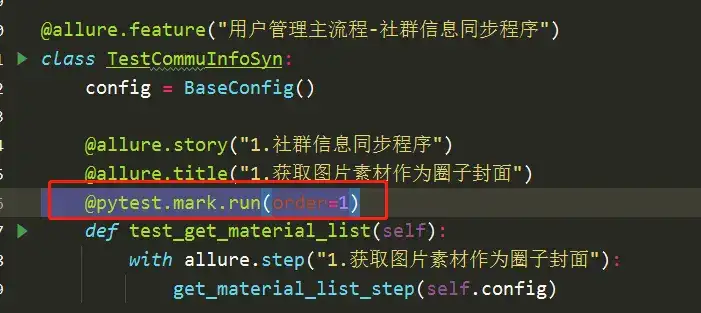

代码示例:

import org.apache.spark.streaming.{Seconds, StreamingContext}

import org.apache.spark.streaming.dstream.DStream

import org.apache.spark.{SparkConf, SparkContext}

object StreamingExample {

def main(args: Array[String]): Unit = {

// 创建 Spark 配置和上下文

val conf = new SparkConf().setMaster("local[*]").setAppName("StreamingExample")

val sc = new SparkContext(conf)

val ssc = new StreamingContext(sc, Seconds(5))

// 从 Twitter 流摄取数据

val stream: DStream[String] = ssc.textFileStream("path/to/twitter/stream")

// 转换和处理流数据

val words: DStream[String] = stream.flatMap(_.split(" "))

val wordCounts: DStream[(String, Int)] = words.map(word => (word, 1)).reduceByKey(_ + _)

// 输出分析结果

wordCounts.print()

// 启动流式上下文

ssc.start()

ssc.awaitTermination()

}

}

流式数据转换

摄取数据后,Spark Streaming 提供了一系列转换操作来处理和转换流数据:

- 映射: 将函数应用于每个数据项。

- 连接: 将流数据中的项与参考数据集连接。

- 聚合: 将数据项分组并应用聚合函数,如求和、平均值和最大值。

流式数据聚合

Spark Streaming 支持流式聚合,允许您对流数据进行复杂的统计分析。聚合操作包括:

- 计数: 计算数据项的数量。

- 求和: 计算数字值的总和。

- 平均值: 计算数字值的平均值。

- 最小值: 查找数据项中的最小值。

构建实时分析应用

使用 Spark Streaming 构建实时分析应用遵循以下步骤:

- 从数据源摄取流数据。

- 使用转换操作处理和转换流数据。

- 应用聚合操作对流数据进行统计分析。

- 将分析结果输出到数据存储或可视化工具中。

最佳实践

- 使用微批处理来提高吞吐量和降低延迟。

- 利用检查点来确保故障恢复。

- 使用数据分区来实现并行处理。

- 优化代码以提高性能。

用例

Spark Streaming 已成功用于广泛的实时分析用例,包括:

- 欺诈检测: 监控交易流以识别可疑活动。

- 客户行为分析: 跟踪用户行为以提供个性化体验。

- 物联网分析: 处理来自传感器和设备的流数据以进行预测性维护和运营优化。

常见问题解答

-

Spark Streaming 和 Apache Flink 有什么区别?

- Spark Streaming 提供了更高的吞吐量,而 Flink 在延迟方面表现更好。

-

如何处理延迟敏感的数据?

- 使用微批处理和优化代码以降低延迟。

-

如何确保数据可靠性?

- 利用检查点和冗余机制来保护数据免遭故障影响。

-

如何扩展 Spark Streaming 应用?

- 使用动态扩展机制或容器编排工具来按需扩展。

-

Spark Streaming 是否支持复杂的事件处理(CEP)?

- Spark Streaming 自身不支持 CEP,但可以通过与其他库(如 Apache Apex)集成来实现 CEP。

结论

Spark Streaming 是一个强大的工具,可帮助您构建高效的实时分析应用。利用其强大的功能,您可以分析海量流数据,做出明智的决策并获得竞争优势。