探究深度学习中的Attention Mechanism:从原理到应用

2023-12-17 05:40:51

Attention Mechanism:深度学习领域的革命

原理

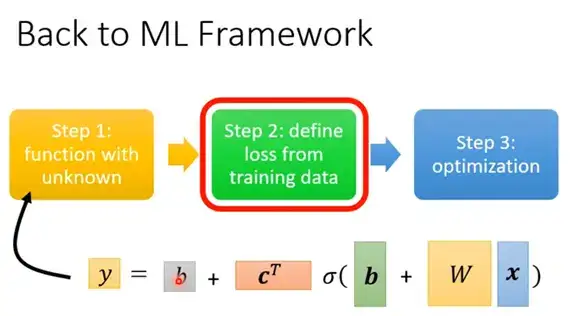

Attention Mechanism(注意力机制)是一种神经网络模块,赋予网络在处理输入序列时对不同元素赋予不同权重的能力。这一机制通过以下步骤实现:

- 计算查询和键的相似性: 首先,计算输入序列中每个元素的查询向量与键向量的相似性。查询向量表示当前任务的上下文,而键向量则代表输入序列中每个元素的信息。

- 计算权重: 利用相似性分数,计算每个元素的权重。这些权重表示元素与当前任务的相关性。

- 加权求和: 最后,将每个元素的权重乘以相应的值向量,并对所有加权值求和,得到最终输出。值向量包含输入序列中每个元素的实际信息。

分类

Attention Mechanism 可分为多种类型,每种类型都适用于特定任务。以下是三种最常见的类型:

- 软 Attention: 使用 softmax 函数计算权重。这一类型最常用,因为它允许平滑地分配权重。

- 硬 Attention: 使用 argmax 函数计算权重。这一类型产生稀疏的权重分布,只关注序列中的少数元素。

- 自 Attention: 在序列中的元素之间计算相似性。这一类型用于 Transformer 模型,无需明确的编码器-解码器结构。

应用

Attention Mechanism 在自然语言处理和计算机视觉等领域有着广泛的应用。以下是一些最常见的应用场景:

- 机器翻译: 允许神经网络专注于输入句子中与当前翻译任务最相关的单词。

- 语音识别: 帮助神经网络识别音频序列中与特定单词或音素相关的帧。

- 图像标注: 允许神经网络关注图像中与特定对象或特征相关的区域。

- 文本摘要: 帮助神经网络从较长的文档中提取关键信息。

- 推荐系统: 可用于根据用户的历史行为对项目进行个性化推荐。

代码示例

以下是用 Python 实现的软 Attention Mechanism 代码示例:

import tensorflow as tf

# 输入序列

input_sequence = [1, 2, 3, 4, 5]

# 查询向量

query_vector = tf.constant([6, 7, 8])

# 计算相似性

similarity_scores = tf.matmul(input_sequence, query_vector)

# 计算权重

weights = tf.nn.softmax(similarity_scores)

# 计算加权和

output = tf.reduce_sum(tf.multiply(weights, input_sequence))

结论

Attention Mechanism 已成为深度学习领域的一项变革性技术,显著提高了神经网络在各种任务上的性能。通过理解 Attention Mechanism 的原理、分类和应用,我们可以更深入地了解其强大功能,并将其应用到我们的机器学习项目中。

常见问题解答

-

Attention Mechanism 适用于哪些任务?

Attention Mechanism 可用于广泛的任务,包括机器翻译、语音识别、图像标注、文本摘要和推荐系统。 -

哪些神经网络架构使用 Attention Mechanism?

Transformer 架构和基于 LSTM 和 GRU 的编码器-解码器模型广泛使用 Attention Mechanism。 -

Attention Mechanism 如何处理长序列?

自 Attention Mechanism 和稀疏 Attention Mechanism 等变体可用于处理长序列,而无需过多的计算成本。 -

Attention Mechanism 如何提高性能?

Attention Mechanism 允许网络专注于输入序列中与当前任务最相关的部分,从而提高性能。 -

在现实世界中,Attention Mechanism 有哪些应用?

Attention Mechanism 用于各种现实世界应用中,包括语言翻译工具、语音助手和图像编辑软件。