深度解读:三大巨头解锁LLM潜力 - WizardLM、反向翻译和SELF-ALIGN技术齐聚

2023-10-25 16:47:32

提升大语言模型性能的种子数据扩展:三种有效方法

引言

大语言模型(LLM)在人工智能领域掀起革命,但其性能高度依赖于高质量数据的充足供应。为了应对这一挑战,研究人员正在积极探索有效的方法,从有限的种子数据中挖掘并扩展高质量标签数据。

在本文中,我们将深入探讨微软、Meta和IBM提出的三种尖端的半监督样本挖掘技术:WizardLM、反向翻译和SELF-ALIGN 。这些技术旨在通过增加种子样本的数量和多样性来提高LLM的性能。

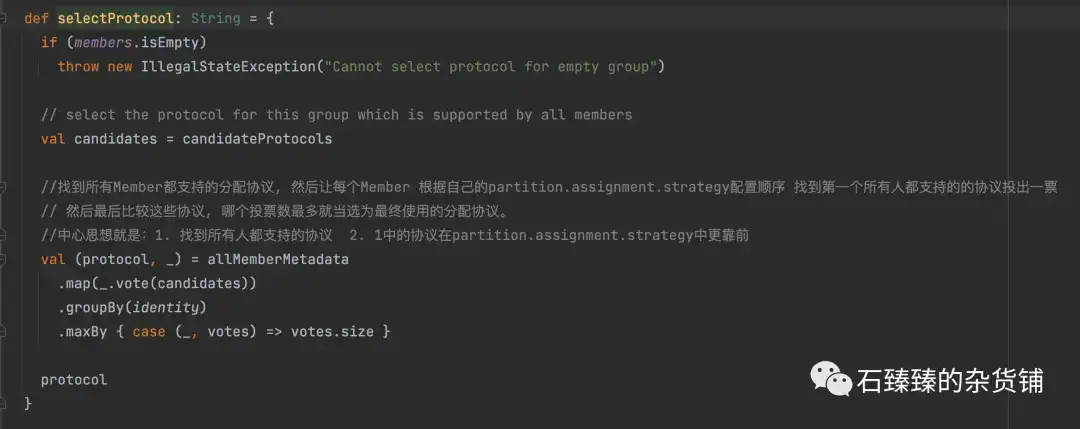

微软的WizardLM:通过扩写和改写扩展数据

微软的WizardLM方案采用了一种新颖的方法,通过扩写和改写现有文本来生成新样本。该方法利用预先定义的"专家模板"来指导新文本的生成,确保新样本包含有价值的信息。例如,如果我们有一个关于旅行的种子样本,WizardLM可以生成一个新样本,其中包含关于某个特定目的地的详细信息和个人经历。

Meta的反向翻译:通过语言转换激发多样性

Meta的反向翻译方案引入了一个创新的概念:将文本翻译成一种外语,然后再翻译回原始语言。这一过程有助于打破文本的现有结构,同时保留其语义内容。通过多次翻译,Meta的方案可以产生一系列具有不同表达方式和结构的新样本,从而显著增加种子数据的多样性。

IBM的SELF-ALIGN:利用预训练模型自动生成

IBM的SELF-ALIGN方案采用了一种基于预训练模型的自动化方法。该方案使用一个经过大量文本数据训练的简单生成模型来创建新样本。通过学习输入文本的模式和结构,生成模型可以产生新的文本,这些文本在内容上与原始文本相似,但在表现形式上有所不同。这一方法节省了时间和资源,同时为LLM提供了丰富且多样的训练数据。

优势与应用

这三种技术共同展示了半监督样本挖掘在扩展种子数据方面的巨大潜力,从而提升了LLM的性能。这些技术具有以下优势:

- 显著增加样本数量: 通过生成新样本,这些技术可以大幅增加种子数据集的大小。

- 提高样本多样性: 通过改变文本的结构和表达方式,这些技术可以创造出具有不同特征和视角的新样本。

- 提高LLM性能: 更大、更多样化的数据集有助于LLM学习更广泛的语言模式和关系,从而提高其在各种任务中的性能。

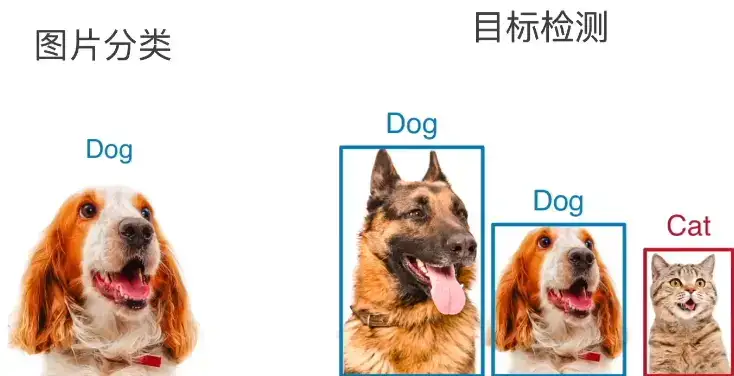

这些技术在自然语言处理、计算机视觉和机器翻译等领域有着广泛的应用。例如,WizardLM可用于生成更丰富的对话数据,反向翻译可用于创建多语言数据集,而SELF-ALIGN可用于自动生成图像标签。

结论

微软的WizardLM、Meta的反向翻译和IBM的SELF-ALIGN代表了半监督样本挖掘技术的最新进展,为提升LLM性能开辟了新的道路。通过有效地扩展种子数据集的数量和多样性,这些技术为机器学习模型提供了更丰富的训练环境,从而释放了人工智能的更大潜力。

常见问题解答

- 什么是半监督样本挖掘?

半监督样本挖掘是一种技术,它利用少量标记数据和大量未标记数据来生成新样本。这些新样本可以用来训练机器学习模型,从而提高其性能。

- 为什么半监督样本挖掘对于LLM很重要?

LLM高度依赖于高质量数据的充足供应。半监督样本挖掘技术可以帮助扩展和多样化种子数据集,从而改善LLM的训练和性能。

- 哪种半监督样本挖掘技术最有效?

最佳技术的选择取决于特定的任务和数据集。WizardLM适合需要详细和特定信息的文本扩展,而反向翻译对于需要语言多样性的任务很有用。SELF-ALIGN提供了一个自动化和高效的方法来生成新样本。

- 半监督样本挖掘技术在哪些领域有应用?

这些技术在自然语言处理、计算机视觉、机器翻译和许多其他领域都有广泛的应用。

- 半监督样本挖掘技术的未来发展趋势是什么?

研究人员正在探索新的技术,例如基于图神经网络的样本挖掘和主动学习,以进一步提高半监督样本挖掘的有效性。