返回

优化波士顿房价预测:随机梯度下降法大显神通

人工智能

2023-09-06 21:15:34

随机梯度下降:优化海量数据集的利器

什么是随机梯度下降?

当面对海量样本数据集时,计算损失函数和梯度的传统方法会变得非常耗时。随机梯度下降 (SGD) 是一种优化算法,通过每次随机选取一小部分样本数据来解决这个问题,大大降低了计算量,使其适用于处理大规模数据集。

SGD 的优点

- 低计算量: SGD 只处理一小部分数据,从而显著降低了计算量。

- 训练速度快: 更低的计算量意味着训练模型所需的时间也大大减少。

- 防止过拟合: SGD 的随机性有助于防止模型对训练数据过拟合,从而提高泛化性能。

- 易于并行化: SGD 可以轻松并行化,这使其非常适合利用多核 CPU 或 GPU 的计算能力。

SGD 的缺点

- 收敛速度慢: SGD 收敛速度可能较慢,尤其是在数据集较大时。

- 模型抖动: SGD 的随机性可能导致模型在训练过程中出现抖动,影响收敛速度和稳定性。

- 局部最优解: SGD 可能会收敛到局部最优解,而不是全局最优解。

如何使用 SGD

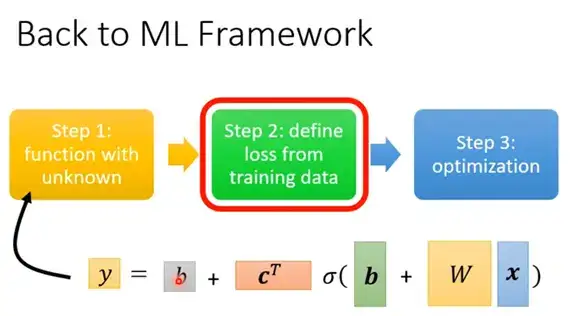

使用 SGD 优化模型通常涉及以下步骤:

- 定义模型和损失函数。

- 选择批量大小(一次处理的数据样本数)。

- 设置学习率(SGD 更新参数的步长)。

- 迭代以下步骤,直到达到停止条件:

- 从训练数据中随机抽取一个批次。

- 计算损失函数和梯度。

- 使用梯度和学习率更新模型参数。

SGD 在波士顿房价预测中的应用

SGD 已成功应用于波士顿房价预测,以提高模型的准确性和性能。它已被证明在减少计算量和提高训练速度的同时,还能保持模型的预测能力。

代码示例

import numpy as np

def sgd(model, loss_function, data, epochs, batch_size, learning_rate):

"""

使用 SGD 优化模型

参数:

model:待优化的模型

loss_function:损失函数

data:训练数据

epochs:训练轮数

batch_size:批量大小

learning_rate:学习率

"""

# 迭代训练轮数

for epoch in range(epochs):

# 遍历数据批次

for batch in range(len(data) // batch_size):

# 随机抽取一个批次

batch_data = data[batch * batch_size:(batch + 1) * batch_size]

# 计算损失函数和梯度

loss, grad = loss_function(model, batch_data)

# 更新模型参数

for param in model.parameters():

param -= learning_rate * grad[param]

return model

常见问题解答

-

SGD 和批量梯度下降 (BGD) 有什么区别?

SGD 每次使用一小部分数据,而 BGD 使用所有数据计算梯度。SGD 计算成本较低,但收敛速度可能较慢,而 BGD 计算成本较高,但通常收敛速度更快。 -

如何选择合适的批量大小?

批量大小是一个超参数,没有固定的规则。一般来说,较小的批量大小会导致较大的模型抖动,而较大的批量大小会导致收敛速度较慢。 -

如何设置学习率?

学习率也是一个超参数,需要根据具体问题进行调整。较高的学习率可能导致模型不稳定,而较低的学习率可能导致收敛速度较慢。 -

如何避免局部最优解?

可以使用动量、RMSprop 或 Adam 等优化器来帮助 SGD 跳出局部最优解。 -

SGD 是否适用于所有问题?

SGD 通常适用于大规模优化问题,但它可能不适用于较小数据集或高度非凸优化问题。