Pandas与Spark的数据读取大比拼:差异与选择之道

2024-02-13 22:12:07

读写格式

Pandas支持多种文件类型,如CSV、Excel、JSON以及SQL等。这些格式在本地处理小规模至中等规模的数据时表现出色。然而,在处理大规模或分布式存储的数据集时,Pandas显得力不从心。

Spark通过提供DataFrame API可以高效地处理大量数据,并且能够读取Parquet、ORC和其他列式存储格式的文件,这在大数据场景下非常有用。Spark也支持CSV和JSON等格式。

分布式计算

对于大规模的数据集,Pandas依赖于单机内存进行运算,这意味着它不擅长处理远超单机内存大小的数据集。相反,Spark设计用于分布式环境,能够将数据分散到多台机器上,并行执行任务,极大提升了处理效率和速度。

灵活模式

在灵活性方面,Pandas提供了丰富的API支持,便于进行复杂的操作。Spark则通过SQL、DataFrame以及RDD(弹性分布式数据集)等多种方式提供灵活的数据处理手段。

内存管理

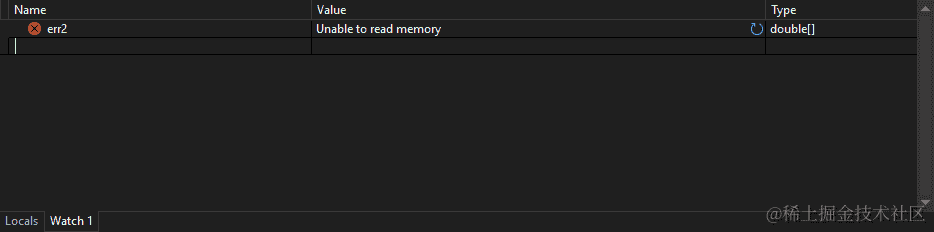

Pandas运行于单机环境中,所有运算都在内存中完成,这可能造成内存溢出的问题。相比之下,Spark具备更高级的内存管理机制,能够动态调整缓存策略和执行计划以适应不同规模的任务需求。

性能比较

在性能上,Pandas对于较小的数据集展现出了惊人的速度,尤其在单机环境下处理数据时显得尤为高效。而对于大规模数据或者需要分布式计算支持的情形,Spark凭借其并行计算能力明显更具优势。

解决方案与示例代码

为了更好地理解这些差异,并提供科学的选择建议,在实际操作中可以根据不同的需求场景选择合适的工具。

Pandas的使用

import pandas as pd

# 读取CSV文件

data = pd.read_csv('example.csv')

print(data.head())

Spark的使用

from pyspark.sql import SparkSession

spark = SparkSession.builder.appName("example").getOrCreate()

# 读取Parquet文件

data = spark.read.parquet("path/to/parquet")

data.show(5)

应用场景建议

- 对于较小规模的数据集,Pandas因其丰富的API和易上手特性是理想的选择。

- 当面对大规模数据处理或需要进行分布式运算时,Spark的并行计算能力和强大的内存管理机制使其成为优选方案。

未来展望

随着技术的发展,两者不断优化与迭代。在选择工具时,根据项目具体需求、团队熟悉程度以及预期性能目标来决定使用Pandas还是Spark更为合适。同时,在一些场景下,也可以尝试结合两种框架的优势进行互补操作,以达到最佳效果。

通过上述对比分析及示例代码展示,开发者可以根据实际情况选取最适合的数据处理框架,为数据科学和工程领域提供坚实的后盾支持。