Transformer理解:一份清晰的指南,轻松掌握注意力机制

2023-11-14 14:20:14

Transformer:揭开自然语言处理领域的革命性模型

了解 Transformer

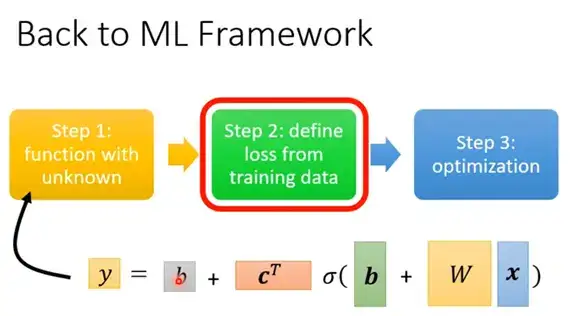

Transformer 是近年来深度学习领域最具突破性的神经网络架构之一。它由谷歌 AI 研究团队于 2017 年提出,专门用于处理序列数据,例如文本和语音。与传统的循环神经网络 (RNN) 和卷积神经网络 (CNN) 相比,Transformer 摒弃了这些架构,转而使用注意力机制。

注意力机制:Transformer 的核心

注意力机制是 Transformer 的核心。它允许模型在处理序列数据时专注于特定部分。通过这种方式,Transformer 能够捕捉长距离依赖关系,这是 RNN 和 CNN 难以做到的。

《Attention Is ALL You Need》:里程碑式的论文

2017 年,谷歌 AI 研究团队发表了标志性的论文《Attention Is ALL You Need》,正式推出了 Transformer 模型。这篇论文展示了 Transformer 在机器翻译任务中的卓越性能,它在质量和并行性方面都优于之前的模型。

Transformer 的优势

Transformer 拥有以下显着的优势:

- 高并行性: Transformer 允许模型在大型数据集上快速训练,并轻松扩展到更大的模型。

- 长距离依赖关系建模: 它能够有效地捕捉序列数据中的长距离依赖关系,这对于自然语言处理和机器翻译至关重要。

- 通用性: Transformer 可广泛应用于各种自然语言处理任务,包括机器翻译、文本摘要、问答系统和文本生成。

Transformer 的应用

Transformer 在自然语言处理和机器翻译领域找到了广泛的应用。它已成为机器翻译中最流行的模型,并被谷歌翻译、微软翻译和亚马逊翻译等在线翻译服务广泛采用。

Transformer 改变了 NLP 格局

Transformer 的出现彻底改变了我们处理序列数据的思维方式。它的高并行性、长距离依赖关系建模能力和通用性使得它成为自然语言处理领域的主导力量。

代码示例:使用 Transformer 进行文本分类

以下 Python 代码示例演示了如何使用 TensorFlow 中的 Transformer 层进行文本分类:

import tensorflow as tf

# 创建 Transformer 层

transformer_layer = tf.keras.layers.TransformerBlock(num_heads=8, d_model=512, dff=2048, rate=0.1)

# 创建模型

model = tf.keras.Sequential([

tf.keras.layers.Embedding(vocab_size, d_model),

transformer_layer,

tf.keras.layers.Dense(num_classes)

])

# 训练模型

model.compile(optimizer='adam', loss='sparse_categorical_crossentropy', metrics=['accuracy'])

model.fit(X_train, y_train, epochs=10)

常见问题解答

-

什么是注意力机制?

注意力机制允许模型在处理序列数据时关注特定部分。 -

为什么 Transformer 优于 RNN 和 CNN?

Transformer 具有更高的并行性,能够捕捉更长的依赖关系,并且更加通用。 -

Transformer 在哪些领域有应用?

Transformer 主要应用于自然语言处理和机器翻译。 -

Transformer 的未来是什么?

Transformer 将继续在自然语言处理领域引领发展,并开创新的应用。 -

如何使用 Transformer 训练我的模型?

可以通过使用 TensorFlow 或 PyTorch 等机器学习库来使用 Transformer 训练模型。