谁是算法的囚徒?

2023-12-13 09:42:42

YouTube和今日头条很委屈?色情暴力的锅推荐系统该不该背?

在社交媒体平台和内容推荐算法主导的互联网时代,YouTube和今日头条这样的内容聚合平台近年来频频陷入内容审核的漩涡。色情、暴力、虚假信息等不当内容充斥着互联网,而这些平台推荐算法是否应当为这些内容的传播承担责任,引发了广泛的争论。

YouTube的“艾莎门”事件将这一问题推向了舆论的风口浪尖。在这一事件中,针对儿童的色情、暴力视频堂而皇之地出现在YouTube的推荐列表中,对儿童的身心健康造成了严重的伤害。家长们愤怒不已,指责YouTube的推荐算法疏于把关,甚至纵容有害内容的传播。

类似的事件也发生在国内的今日头条等信息平台上。这些平台的推荐算法被指责存在“标题党”、“虚假信息”等问题,误导用户并损害了平台的公信力。

面对舆论的压力,YouTube和今日头条等平台一方面加强了内容审核的力度,另一方面也开始反思自己的推荐算法。但究竟该如何平衡平台的盈利和内容的健康?推荐算法在其中应该扮演怎样的角色?这些问题至今仍悬而未决。

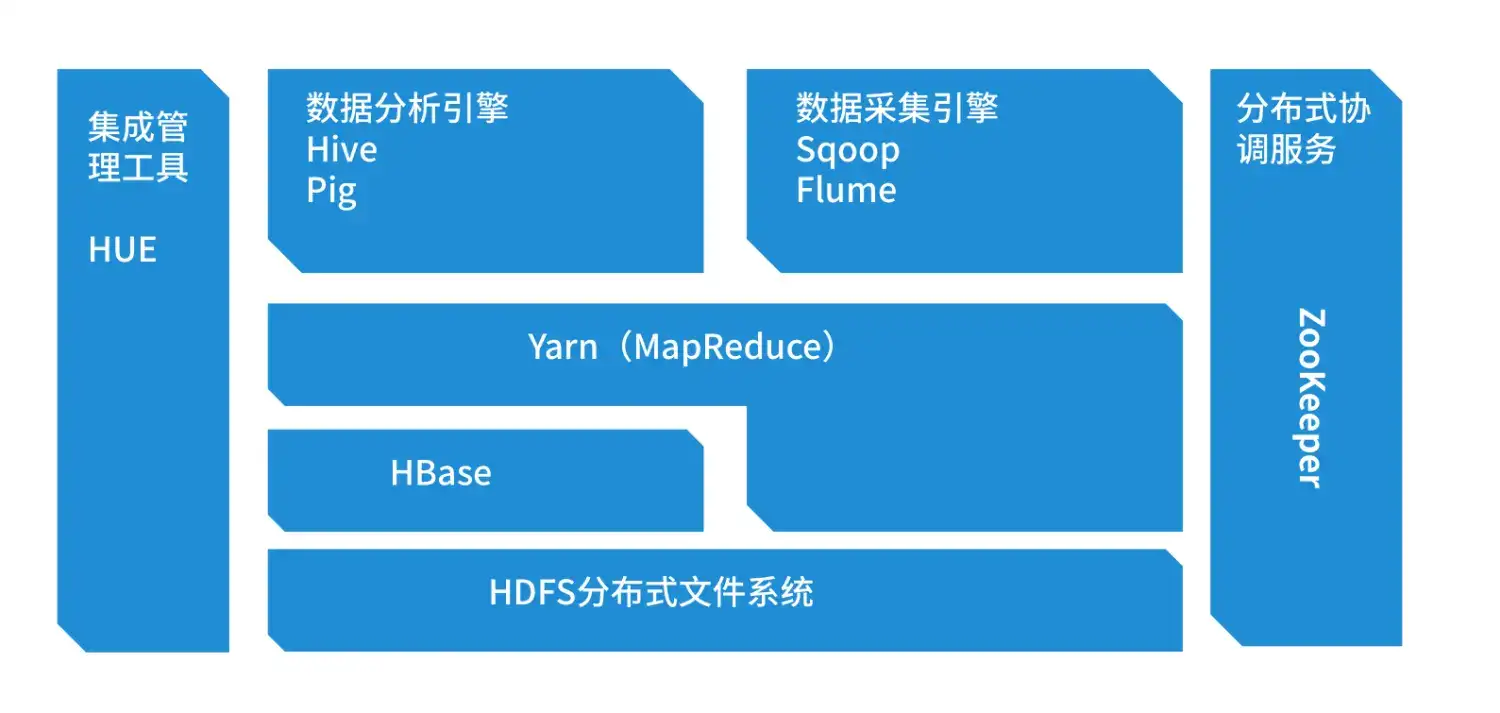

推荐算法是一套基于用户兴趣和行为数据,对内容进行个性化推荐的技术。它能够为用户提供更加符合其需求的内容,提高用户粘性和满意度。

然而,推荐算法也存在着固有的缺陷。由于算法的透明度和可解释性普遍较低,用户难以了解推荐机制的运作原理。这使得算法有可能存在偏见、歧视和过滤气泡等问题。

推荐算法的偏见主要源于训练数据中的偏见。如果训练数据中存在对某些群体或观点的偏见,那么算法也会继承这些偏见。例如,一项研究发现,谷歌的推荐算法对女性和少数族裔的招聘广告存在歧视。

推荐算法还会创造出所谓的“过滤气泡”,即用户只会接触到算法推荐的符合其现有偏好的内容,而无法接触到其他观点和信息。这会导致用户的思想变得更加极端,并难以形成全面的世界观。

面对推荐算法的负面影响,我们不能简单地将其妖魔化或束之高阁。相反,我们需要探索切实可行的应对措施,既能保障平台的盈利和用户体验,又能防止有害内容的传播。

提高推荐算法的透明度和可解释性至关重要。平台应该向用户公开算法的运作原理,并提供用户自定义推荐设置的选项。只有当用户了解算法是如何工作的,他们才能对算法的推荐做出明智的判断。

政府和行业协会可以建立第三方监管机制,对推荐算法的运作进行监督和评估。这些机制可以制定行业标准,并对违反标准的平台进行处罚。

提升用户对推荐算法的认识和素养也非常重要。教育用户如何识别偏见和过滤气泡,以及如何主动探索不同观点。

平台在内容审核和算法治理方面负有不可推卸的责任。除了加强内部监管,平台还应与用户、创作者、监管机构和行业协会合作,共同构建一个更加健康和多元的内容生态。

总之,推荐算法是一把双刃剑,既能提高用户体验,又能带来有害内容的传播。如何平衡算法的利弊,是平台、用户和监管机构共同面临的挑战。只有通过算法透明度、第三方监管、用户教育和平台责任等多管齐下的措施,我们才能最大程度地发挥算法的正面作用,避免其负面影响。