深度学习的可解释性:解锁模型决策背后的秘密

2024-02-25 17:00:05

深度学习的可解释性:解锁模型潜力

引言

深度学习已经改变了各个行业的面貌,从计算机视觉到自然语言处理。然而,随着模型变得越来越复杂,理解它们做出决策背后的原因也变得越来越具有挑战性。可解释性对于建立对模型的信任、确保公平性和改进性能至关重要。本文将探讨深度学习的可解释性及其对模型发展的影响。

什么是可解释性?

可解释性是指模型对人类理解的程度。它允许我们了解模型是如何工作的、做出哪些预测以及为什么做出这些预测。可解释性对于以下方面至关重要:

- 建立对模型的信任

- 检测模型偏见

- 发现模型错误

- 指导模型改进

提高深度学习可解释性的技术

近年来,已经开发了许多技术来提高深度学习模型的可解释性,包括:

特征重要性分析

识别对模型预测贡献最大的输入特征。这有助于理解模型的决策基础。

注意力机制

可视化模型在输入数据上关注的区域。这提供了有关模型如何处理输入的见解。

对抗性示例

生成最小扰动输入,导致模型做出错误预测。这有助于识别模型的脆弱性并提高鲁棒性。

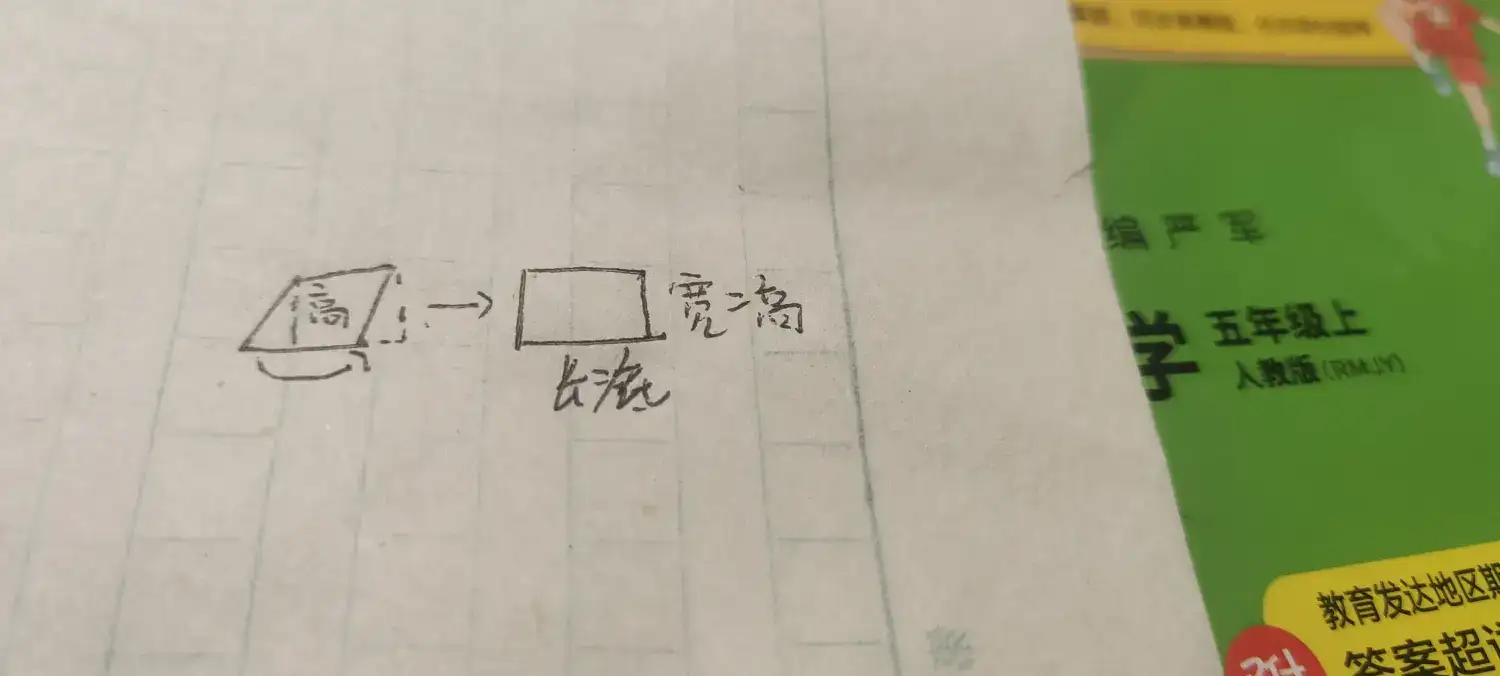

解释性图

通过绘制一个图来表示模型的决策过程,揭示其内部机制。

可解释性对深度学习发展的影响

可解释性在深度学习的发展中发挥着至关重要的作用:

提高模型可靠性

通过理解模型的决策过程,我们可以更相信其预测结果。

检测模型偏见

可解释性技术可以帮助识别和消除模型中的偏见,从而确保公平和无歧视的预测。

促进模型改进

了解模型的弱点可以指导模型的改进,提高其性能和鲁棒性。

促进行业应用

可解释性是深度学习在医疗保健、金融和制造业等受监管行业的应用的关键因素。

展望

随着深度学习技术的发展,对可解释性需求也会不断增长。未来,可解释性将成为深度学习模型设计和部署的不可或缺的一部分。

常见问题解答

1. 可解释性为何如此重要?

可解释性对于建立对模型的信任、检测偏见、发现错误和指导模型改进至关重要。

2. 有哪些可解释性技术可用?

常见的可解释性技术包括特征重要性分析、注意力机制、对抗性示例和解释性图。

3. 可解释性如何影响深度学习的发展?

可解释性提高了模型的可靠性、公平性和性能,促进了深度学习在各个行业的应用。

4. 未来可解释性研究的趋势是什么?

未来的研究将关注开发新的可解释性技术、改善现有技术的有效性和在现实世界应用中应用可解释性。

5. 可解释性是否限制了深度学习模型的性能?

可解释性可以帮助识别和修复模型中的问题,从而在某些情况下提高性能。但是,过度追求可解释性可能会损害模型的准确性。

结论

可解释性是深度学习发展的关键因素。它提高了模型的可靠性、公平性和性能,促进了深度学习在广泛行业的应用。随着深度学习技术不断发展,可解释性将变得越来越重要,确保模型不仅强大,而且可靠且可理解。