返回

L1与L2正则化:深度学习中的过拟合克星

人工智能

2024-02-02 23:17:14

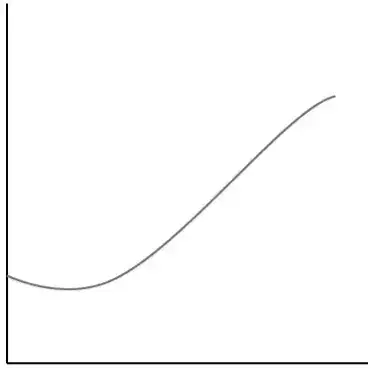

过拟合是深度学习模型的常见问题,会导致模型对训练数据过度拟合,而对新数据泛化能力差。为了解决这个问题,正则化技术可以帮助我们在训练过程中引入一些约束,防止模型过度拟合。本文将深入探讨两种常用的正则化技术:L1正则化和L2正则化。

L1正则化(LASSO)

L1正则化,也称为LASSO(最小绝对收缩和选择算子),通过向损失函数中添加权重项来惩罚权重的绝对值之和。数学表达式为:

loss = original_loss + lambda * ||w||_1

其中:

- original_loss是原始的损失函数

- lambda是正则化超参数,控制正则化项的强度

- ||w||_1是权重向量的L1范数,即权重绝对值之和

L1正则化的优点:

- 倾向于产生稀疏权重,即许多权重被强制为零。这可以实现特征选择,有助于识别最重要的特征。

- 在高维数据中表现良好,因为它倾向于选择少数重要的特征,而忽略噪声特征。

L1正则化的缺点:

- 计算成本较高,因为需要使用特殊的优化算法。

- 可能导致模型不稳定,因为权重的稀疏性可能会对微小的训练数据变化敏感。

L2正则化(权重衰减)

L2正则化,也称为权重衰减,通过向损失函数中添加权重平方和来惩罚权重的幅度。数学表达式为:

loss = original_loss + lambda * ||w||_2^2

其中:

- original_loss是原始的损失函数

- lambda是正则化超参数,控制正则化项的强度

- ||w||_2^2是权重向量的L2范数,即权重平方和

L2正则化的优点:

- 计算成本较低,可以与标准优化算法一起使用。

- 倾向于产生平滑的权重,有助于防止模型过拟合。

- 在低维数据中表现良好,因为它可以有效地减小权重的幅度。

L2正则化的缺点:

- 不会产生稀疏权重,因此无法实现特征选择。

- 在高维数据中可能效果较差,因为所有权重都会受到惩罚,包括重要的特征。

选择L1或L2正则化

选择L1或L2正则化取决于具体的数据集和建模目标:

- 如果目标是特征选择,则L1正则化更合适。

- 如果目标是防止过拟合,则L2正则化更合适。

- 在高维数据中,L1正则化更合适,而在低维数据中,L2正则化更合适。

超参数调整

正则化超参数lambda控制正则化项的强度。较大的lambda值会导致更强的正则化,有助于防止过拟合,但可能降低模型的泛化能力。较小的lambda值会导致较弱的正则化,有助于提高模型的泛化能力,但可能导致过拟合。

选择最佳的lambda值可以通过交叉验证来完成。将训练数据集划分为训练集和验证集,并针对不同的lambda值训练模型。选择在验证集上具有最低验证误差的lambda值。

结论

L1和L2正则化是深度学习中常用的两种正则化技术,可帮助防止模型过拟合。L1正则化倾向于产生稀疏权重,而L2正则化倾向于产生平滑的权重。选择合适的正则化技术和超参数对于构建泛化能力强且不容易过拟合的深度学习模型至关重要。