返回

广播机制:TensorFlow 和 NumPy 中的魔术武器

人工智能

2023-11-09 20:15:08

在机器学习和深度学习领域,高效地处理数据至关重要。NumPy 和 TensorFlow 是两个广受欢迎的库,提供了一套强大的工具来操纵和处理数据。其中一个关键特征是广播机制,它允许将不同形状的数组无缝地组合在一起进行算术运算。

NumPy 中的广播

NumPy 的广播机制允许对具有不同形状的数组执行逐元素运算。当数组具有不同形状时,较小的数组会沿着较大的数组的轴扩展,以匹配其形状。例如:

import numpy as np

a = np.array([1, 2, 3])

b = np.array([[4, 5], [6, 7]])

print(a + b) # 输出:[5 7 9]

在上面示例中,数组 a 形状为 (3,) 而数组 b 形状为 (2, 2)。NumPy 广播 a 使其具有形状 (2, 3),使其与 b 的形状匹配。然后,逐元素相加操作被应用于这两个数组。

TensorFlow 中的广播

TensorFlow 也支持广播,允许对张量执行逐元素运算。张量是 TensorFlow 中多维数据的表示。与 NumPy 类似,TensorFlow 广播较小的张量以匹配较大的张量。例如:

import tensorflow as tf

a = tf.constant([1, 2, 3])

b = tf.constant([[4, 5], [6, 7]])

print(a + b) # 输出:[5 7 9]

在 TensorFlow 中,广播遵循与 NumPy 相同的规则。较小的张量 a 被广播到形状 (2, 3),然后与较大的张量 b 逐元素相加。

广播的规则

广播遵循以下规则:

- 只有形状不同的维度才会广播。

- 维度可以广播到任意长度。

- 广播的维度必须是 1。

- 如果两个维度都为 1,则它们不会广播,并且必须相等。

广播的优势

广播机制提供了许多优势,包括:

- 简洁性: 它允许对不同形状的数组进行简单的逐元素运算,而无需手动调整形状。

- 效率: 广播消除了对昂贵的形状转换操作的需要,从而提高了运算效率。

- 灵活性: 它支持多种数组和张量形状,使数据处理更加灵活。

实例

广播机制在机器学习和深度学习中有很多应用,包括:

- 图像处理: 对不同大小的图像应用卷积和池化操作。

- 序列建模: 将不同的时间步长和批次大小的序列合并起来进行训练。

- 并行计算: 将数据拆分成较小的块,并在并行设备上进行分布式处理。

限制

尽管广播非常有用,但也有以下一些限制:

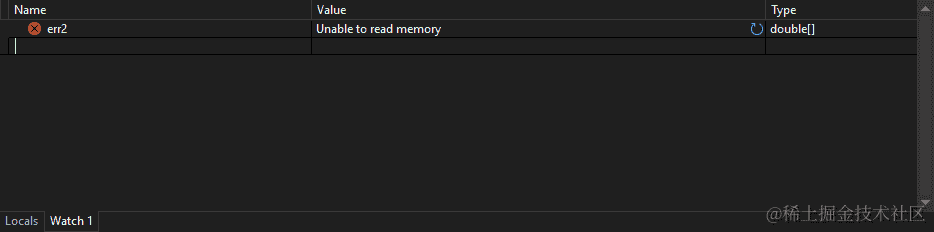

- 内存开销: 广播可能会导致复制和扩展数组,增加内存消耗。

- 不支持非数值类型: 广播仅支持数值类型,不适用于字符串或其他类型的数据。

- 复杂性: 在处理复杂形状的数据时,理解广播规则可能会变得具有挑战性。

结论

广播机制是 TensorFlow 和 NumPy 中一个强大的工具,它允许对不同形状的数组和张量进行高效的逐元素运算。通过理解广播的规则和优势,您可以充分利用它来简化数据处理并提高机器学习和深度学习应用程序的性能。