返回

直观比较四种NLP模型:神经网络、RNN、CNN、LSTM

人工智能

2023-12-30 19:58:27

导言

自然语言处理(NLP)是人工智能的一个分支,它赋予计算机理解和处理人类语言的能力。在NLP领域,有各种模型被用来解决不同的语言处理任务。其中,四种最常用的模型是神经网络、循环神经网络(RNN)、卷积神经网络(CNN)和长短期记忆(LSTM)网络。

本文将深入探究这四种模型,详细分析它们的差异、优缺点,以及它们在NLP中的具体应用。

神经网络

神经网络是NLP中使用最广泛的模型类型之一。它们由相互连接的层组成,每层由一组人工神经元组成。神经元接收输入,应用非线性函数,然后产生输出。通过多个层的级联处理,神经网络可以学习复杂模式和关系。

优点:

- 强大的特征学习能力

- 对非线性数据的鲁棒性

- 可扩展性,可处理大量数据

缺点:

- 训练时间长

- 可能容易过拟合

- 缺乏对序列数据的建模能力

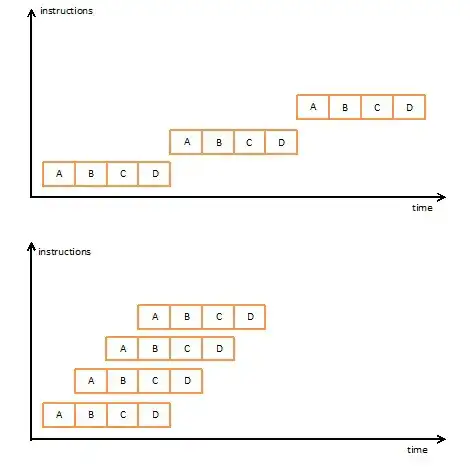

RNN

RNN是专门设计用于处理序列数据的变体神经网络。与标准神经网络不同,RNN在每个时间步长都会将前一个时间步长的输出作为输入。这种反馈循环使RNN能够捕获序列数据中的依赖关系。

优点:

- 序列建模能力

- 适用于时间序列数据分析

- 可以处理可变长度的序列

缺点:

- 梯度消失/爆炸问题

- 训练困难,尤其是对于长序列

- 计算成本高

CNN

CNN是另一种广泛用于NLP的变体神经网络。它们具有一个卷积层,该卷积层会应用卷积核来提取输入数据中的局部特征。卷积核在数据中滑动,生成特征图,这些特征图捕获输入中的重要模式。

优点:

- 对位置不变性的鲁棒性

- 可从文本中提取局部特征

- 在处理高维数据方面效率很高

缺点:

- 无法处理序列数据

- 对超参数的敏感性

- 计算成本高

LSTM

LSTM是RNN的一个特殊类型,专为解决梯度消失/爆炸问题而设计。LSTM具有一个记忆单元,用于存储长期依赖关系。门控机制控制信息流入和流出记忆单元,从而使LSTM能够学习复杂的时间序列数据。

优点:

- 长期依赖建模能力

- 克服了RNN的梯度消失/爆炸问题

- 适用于时间序列预测和语言建模

缺点:

- 比标准RNN训练速度慢

- 计算成本更高

- 可能难以优化超参数

比较和应用

这四种模型各有优势和劣势,其选择取决于特定的NLP任务。

- 神经网络: 适用于一般特征学习和非线性数据分类。

- RNN: 适用于序列建模,如语言建模和时间序列分析。

- CNN: 适用于提取局部特征和处理高维数据。

- LSTM: 适用于建模长期依赖关系和时间序列预测。

结论

神经网络、RNN、CNN和LSTM是NLP中最重要的模型。通过了解这四种模型之间的差异,我们可以做出明智的选择,以解决手头的特定任务。随着NLP的不断发展,这些模型的应用只会越来越多,为自然语言处理领域打开新的可能性。