Spark SQL 在 IntelliJ IDEA 中的配置和开发

2024-02-13 07:45:00

在现代数据分析流程中,Spark SQL 已成为不可或缺的工具,它作为 Apache Spark 的 SQL 接口,简化了对大规模数据集的处理。本教程将指导您在 IntelliJ IDEA 中配置和开发 Spark SQL 应用程序,让您充分利用这款强大的工具。

配置 Spark SQL

-

添加依赖项:

在 IntelliJ IDEA 中,打开您的项目并添加以下依赖项到您的 Maven 或 Gradle 构建文件中:

<dependency> <groupId>org.apache.spark</groupId> <artifactId>spark-sql</artifactId> <version>3.3.1</version> </dependency> -

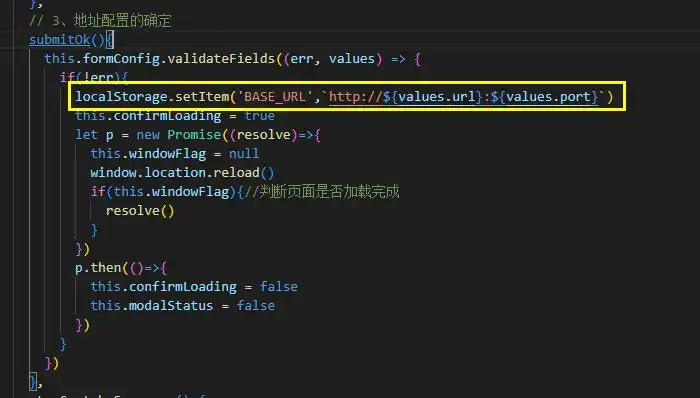

验证配置:

重新构建您的项目以确保依赖项已正确添加。转到“运行”>“编辑配置”并选择您的 Spark 应用程序。在“配置选项”选项卡下,确保已选中“启用 Spark 支持”复选框。

创建 Spark SQL 项目

-

新建项目:

在 IntelliJ IDEA 中,创建一个新的 Java 项目。在“文件”>“新建”>“项目”中,选择“Java”并为项目命名。

-

导入 Spark SQL:

在您的项目中,创建一个新的包并导入 Spark SQL 类:

import org.apache.spark.sql.SparkSession;

加载数据

-

创建 Spark 会话:

创建 Spark 会话以与 Spark 集群交互:

SparkSession spark = SparkSession.builder() .master("local") .appName("Spark SQL Example") .getOrCreate(); -

加载数据:

使用 Spark SQL DataFrames 从文件或数据库加载数据:

DataFrame df = spark.read() .option("header", "true") .option("inferSchema", "true") .csv("path/to/data.csv");

执行查询

-

执行 SQL 查询:

使用 Spark SQL 执行 SQL 查询:

DataFrame result = spark.sql("SELECT * FROM df WHERE age > 18"); -

查看结果:

可以使用 collect() 方法将结果收集到本地集合中或使用 show() 方法将结果打印到控制台中:

result.show();

更多特性

-

使用 UDF:

使用自定义函数 (UDF) 扩展 Spark SQL 的功能:

spark.udf().register("add_one", (Integer x) -> x + 1, DataTypes.IntegerType); -

优化性能:

使用缓存、分区和调优选项来提高 Spark SQL 查询的性能。

-

与其他语言集成:

Spark SQL 可以与 Python、Scala 和其他编程语言集成,以满足不同的开发需求。

结论

通过遵循本教程,您已成功配置和开发了 Spark SQL 应用程序。您现在可以使用 Spark SQL 的强大功能来分析和处理大规模数据集,从而做出明智的业务决策。继续探索 Spark SQL 的更多高级特性,如机器学习、流处理和数据可视化,以充分利用这一强大的数据分析工具。