返回

提升学习算法:揭开 AdaBoost 和 Gradient Boosting 的神秘面纱

人工智能

2024-01-27 15:30:08

引言

集成学习是机器学习中的一个强大范式,它将多个较弱的学习器组合成一个更强大的学习器。通过利用多样性原理,集成学习方法可以克服单个学习器在泛化性能和鲁棒性方面的限制。提升法是一种特定的集成学习技术,它通过迭代地训练弱学习器,并根据其性能调整训练数据的权重,逐步构建一个强学习器。

在本文中,我们将重点探讨提升法中的两种流行算法:AdaBoost 和 Gradient Boosting。我们将深入了解它们的原理、优势和应用,以便您做出明智的决策,选择最适合您的机器学习项目的算法。

AdaBoost

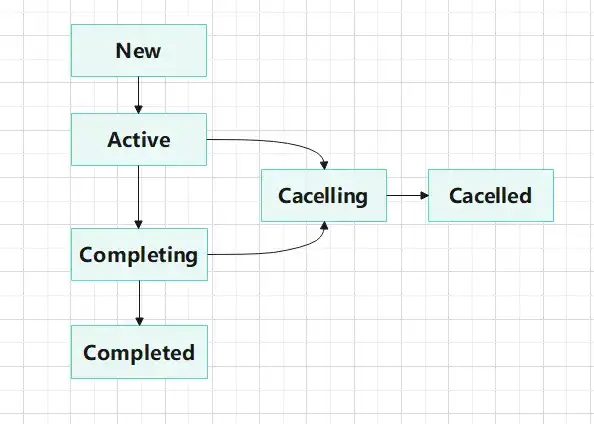

AdaBoost(自适应提升法)是一种提升法算法,它根据每个弱学习器的错误率调整训练数据的权重。具体来说,它按照以下步骤工作:

- 初始化: 给每个训练样本相同的权重。

- 迭代:

- 训练一个弱学习器。

- 计算每个弱学习器的错误率。

- 增加错误分类样本的权重,减少正确分类样本的权重。

- 加权投票: 将所有弱学习器加权投票,其中权重与它们的错误率成反比。

- 重复步骤 2 和 3, 直到达到预定义的迭代次数或满足停止条件。

AdaBoost 的主要优点包括:

- 算法简单易懂,易于实现。

- 对于二分类问题,AdaBoost 算法的理论保证非常强。

- 即使弱学习器的性能很弱,AdaBoost 算法也能产生强大的学习器。

Gradient Boosting

Gradient Boosting是一种提升法算法,它通过逐次拟合残差来构建强学习器。具体来说,它按照以下步骤工作:

- 初始化: 从一个简单模型(例如,决策树)开始。

- 迭代:

- 计算训练数据的残差(预测值和真实值之间的差值)。

- 训练一个新的弱学习器来拟合残差。

- 将新的弱学习器添加到模型中,更新预测值。

- 重复步骤 2, 直到达到预定义的迭代次数或满足停止条件。

Gradient Boosting 的主要优点包括:

- 可以处理各种机器学习任务,包括回归和分类。

- 算法的鲁棒性很强,对超参数不敏感。

- 可以并行化,这使得它在处理大数据集时非常高效。

AdaBoost 与 Gradient Boosting 的比较

AdaBoost 和 Gradient Boosting 是两种功能强大的提升法算法,但在以下几个方面存在差异:

- 损失函数: AdaBoost 使用指数损失函数,而 Gradient Boosting 使用二次损失函数。

- 拟合残差: AdaBoost 直接拟合训练样本,而 Gradient Boosting 拟合残差。

- 适用性: AdaBoost 通常适用于二分类问题,而 Gradient Boosting 可用于回归和分类问题。

- 计算成本: Gradient Boosting 的计算成本通常高于 AdaBoost。

应用场景

AdaBoost 和 Gradient Boosting 已成功应用于广泛的机器学习任务中,包括:

- 图像识别

- 自然语言处理

- 推荐系统

- 金融预测

- 医疗诊断

结论

提升法是机器学习中的一个有力工具,它可以提高弱学习器的性能。AdaBoost 和 Gradient Boosting 是提升法中最流行的两种算法,它们各自具有独特的优势和应用场景。通过了解这些算法的工作原理和差异,您可以为您的项目选择最合适的算法,并获得强大的机器学习模型。